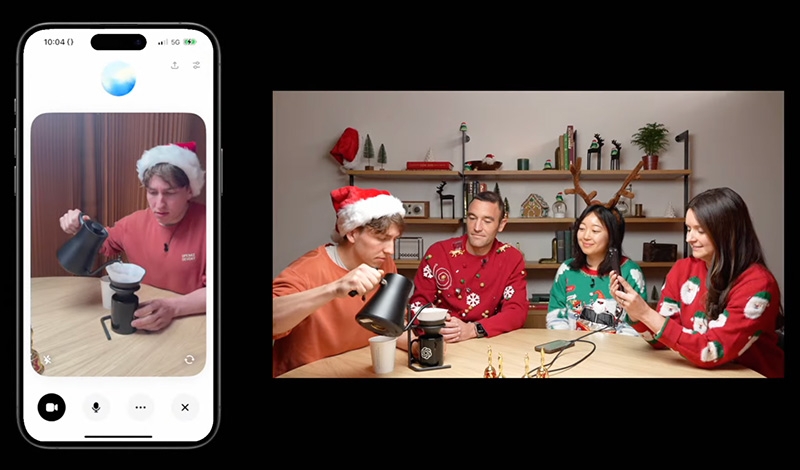

OpenAI объявила о появлении у чат-бота ChatGPT на базе генеративного интеллекта способности обрабатывать видеопоток и говорить с пользователями о том, что он «наблюдает» с помощью камеры смартфона или компьютера, либо что видит на экране устройства. Новая функция доступна в расширенном голосовом режиме (Advanced Voice Mode).

О том, что ChatGPT получит функцию компьютерного зрения, позволяющую ему «видеть» при помощи камеры смартфона пользователя или через трансляцию экрана, компания объявила в мае этого года. Теперь доступ к функции расширенного голосового режима ChatGPT с распознаванием видео получили владельцы платных подписок ChatGPT Plus, Team и Pro. По словам компании, подписчики ChatGPT Enterprise и Edu не получат эту функцию до января, и что пока нет графика по её запуску в ЕС, Швейцарии, Исландии, Норвегии и Лихтенштейне.

В недавней демонстрации в программе CNN «60 минут» президент OpenAI Грег Брокман (Greg Brockman) провел тестирование расширенного голосового режима с визуальным распознаванием с участием телеведущего Андерсона Купера (Anderson Cooper) на предмет анатомических навыков чат-бота. Когда Купер рисовал части тела на доске, ChatGPT «понимал», что тот рисует. Вместе с тем ChatGPT в этом режиме допустил ошибку в задаче по геометрии, что говорит о его склонности к галлюцинациям.

После анонса в мае компания несколько раз откладывала запуск расширенного голосового режима с визуальным распознаванием. В апреле OpenAI пообещала, что этот режим будет доступен для пользователей «в течение нескольких недель», но спустя несколько месяцев признала, что на это потребуется больше времени, чем планировалось. И когда расширенный голосовой режим запустили для некоторых пользователей в сентябре, у него не было функции компьютерного зрения.

Компании Google и Meta✴ тоже работают над аналогичными возможностями для своих чат-ботов. На этой неделе Google сделала функцию ИИ для анализа видео в реальном времени Project Astra доступной для группы «доверенных тестировщиков» на платформе Android.